통계 기반 접근법이란?

자연어 처리 분야에서는 대량의 텍스트 데이터를 이용하여 자연어를 처리하는 방법으로, 통계 기반 접근법과 딥 러닝 기반 접근법이 주로 사용됩니다. 이번 포스트에서는 통계 기반 접근법에 대해 다뤄보도록 하겠습니다.

통계 기반 접근법의 개념과 특징

통계 기반 접근법은 대량의 텍스트 데이터를 이용하여 단어나 문장의 확률 모델을 구축하고, 이를 바탕으로 자연어를 처리하는 방법입니다. 이 방법은 주어진 데이터로부터 단어와 단어 간의 관계를 파악하고, 문장의 구조를 이해할 수 있도록 합니다.

통계 기반 접근법은 다음과 같은 특징을 가집니다.

- 텍스트 데이터 기반: 통계 기반 접근법은 대량의 텍스트 데이터를 기반으로 합니다. 따라서, 입력 데이터에 대한 사전 지식이 필요하지 않으며, 데이터만 있다면 어떤 언어에 대해서도 적용할 수 있습니다.

- 확률 모델 기반: 통계 기반 접근법은 확률 모델을 이용하여 자연어를 처리합니다. 이는 입력 데이터에 대한 확률 분포를 모델링함으로써 자연어의 문법 구조와 의미 정보를 파악할 수 있도록 합니다.

- 피처 기반: 통계 기반 접근법에서는 입력 데이터에서 피처를 추출하여 확률 모델의 입력으로 사용합니다. 이를 통해, 단어나 문장에 대한 다양한 정보를 추출하여 모델이 학습할 수 있도록 합니다.

통계 기반 접근법의 장단점

통계 기반 접근법은 다음과 같은 장단점을 가집니다.

장점

- 대량의 텍스트 데이터를 이용하여 자연어 처리를 수행하기 때문에, 다양한 언어에 적용 가능합니다.

- 확률 모델을 이용하여 자연어의 문법 구조와 의미 정보를 파악할 수 있습니다.

- 입력 데이터에서 다양한 피처를 추출하여 모델 학습에 사용할 수 있습니다.

- 피처 추출 과정에서 사전 지식이 필요하지 않습니다.

- 계산량이 상대적으로 적어, 속도가 빠릅니다.

단점

- 통계 기반 접근법은 데이터에 의존하므로, 데이터가 부족하거나 편향적일 경우 성능이 저하될 수 있습니다.

- 전체 문장을 고려하지 않고 각 단어를 독립적으로 처리하므로, 문맥을 고려하지 않을 수 있습니다.

- 정확도가 딥 러닝 기반 접근법에 비해 낮을 수 있습니다.

통계 기반 품사 태깅이란?

통계 기반 품사 태깅의 개념과 목적

통계 기반 품사 태깅(Statistical Part-of-Speech Tagging)은 자연어 처리 분야에서 매우 중요한 작업 중 하나입니다. 주어진 문장에 대해 단어들의 품사를 태깅함으로써 문장 내의 단어들을 파악하고, 문법적 구조와 의미를 이해할 수 있습니다. 이를 통해 기계 번역, 정보 검색, 문서 분류 등 다양한 자연어 처리 문제를 해결하는 데 활용됩니다.

통계 기반 품사 태깅에 사용되는 알고리즘

통계 기반 품사 태깅에는 다양한 알고리즘이 사용됩니다. 여기에서는 그 중에서도 대표적인 두 가지 알고리즘인 Hidden Markov Model(HMM)과 Conditional Random Field(CRF)에 대해 살펴보겠습니다.

Hidden Markov Model(HMM)

Hidden Markov Model은 확률적인 시계열 데이터를 다루는 데 사용되는 모델입니다. 통계 기반 품사 태깅에서는 HMM을 이용하여 문장 내의 각 단어에 대한 품사를 태깅합니다. 이를 위해 HMM은 문장 내의 각 단어를 상태(state)로 간주하고, 각 상태에서 다음 단어가 나타날 확률을 예측합니다.

HMM을 이용한 품사 태깅에서는 문장 내에서 각 단어의 품사가 이전 단어들의 품사와 주변 단어들의 품사에 영향을 받는다고 가정합니다. 이를 위해 HMM은 문맥을 고려하여 각 단어에 대한 품사를 태깅합니다.

Conditional Random Field(CRF)

Conditional Random Field는 HMM과 유사한 모델로, 시퀀스 레이블링 문제를 다루는 데 사용됩니다. HMM과 달리, CRF는 문장 내에서 각 단어의 품사를 태깅할 때, 전체 문장을 고려하여 태깅합니다. 이를 통해 문맥을 고려한 정확한 품사 태깅을 수행할 수 있습니다.

CRF는 특히 피처 기반의 확률 모델을 사용하기 때문에,HMM과 비교하여 입력 데이터에서 다양한 피처를 추출할 수 있다는 장점이 있습니다. 또한, CRF는 HMM보다 문맥을 보다 잘 파악하고, 전체 문장을 고려한 태깅이 가능하다는 장점이 있습니다.

HMM을 이용한 품사 태깅

HMM의 개념과 특징

Hidden Markov Model(HMM)은 확률적인 시계열 데이터를 다루는 데 사용되는 모델입니다. HMM은 현재 상태에서 나타난 관측값(observable event)의 확률 분포와, 다음 상태로 전환될 확률을 모델링합니다.

HMM은 다음과 같은 특징을 가집니다.

- 현재 상태는 이전 상태에만 영향을 받으며, 현재 상태 이전의 모든 상태는 무시됩니다.

- 현재 상태에서 나타난 관측값은 현재 상태에만 영향을 받으며, 다른 관측값과 상태는 독립적입니다.

- HMM은 다음 상태의 확률 분포가 이전 상태에만 영향을 받으며, 현재 상태와 관측값과는 독립적입니다.

HMM을 이용한 품사 태깅 과정

HMM을 이용한 품사 태깅은 다음과 같은 과정으로 이루어집니다.

- 훈련 데이터셋에서 각 단어와 품사의 조합에 대한 빈도수를 계산합니다.

- 각 단어의 시작과 끝에 <start>와 <end> 태그를 추가합니다.

- 각 단어에 대해 가능한 모든 품사에 대한 확률을 계산합니다.

- 문장 내의 각 단어에 대해, 이전 단어의 품사와 주변 단어들의 품사에 따라 가장 확률이 높은 품사를 부여합니다.

- 태깅된 문장의 정확도를 평가합니다.

Python을 사용한 HMM 품사 태깅 예제 코드

Python의 nltk 라이브러리를 사용하여 HMM을 이용한 품사 태깅을 수행할 수 있습니다. 아래는 예제 코드입니다.

import nltk

# 학습 데이터 로드

tagged_sentences = nltk.corpus.treebank.tagged_sents()

# HMM 모델 학습

hmm_trainer = nltk.tag.hmm.HiddenMarkovModelTrainer()

hmm_tagger = hmm_trainer.train_supervised(tagged_sentences)

# 테스트 문장 태깅

test_sentence = "This is a test sentence."

tagged_words = hmm_tagger.tag(nltk.word_tokenize(test_sentence))

print(tagged_words)

위 예제 코드에서는 NLTK의 treebank 데이터셋에서 학습 데이터를 로드한 후, Hidden MarkovModelTrainer를 이용하여 HMM 모델을 학습합니다. 그리고, 테스트 문장을 입력받아 학습된 모델을 이용하여 품사 태깅을 수행합니다.

위의 예제 코드를 실행하면, "This is a test sentence."라는 문장의 각 단어에 대한 품사 태깅 결과가 출력됩니다.

HMM을 이용한 품사 태깅은 간단한 방법이지만, 문맥을 고려하지 않기 때문에 정확도가 떨어질 수 있습니다. 따라서, 좀 더 정확한 품사 태깅을 위해서는 CRF 등 다른 알고리즘을 이용해야 합니다.

CRF를 이용한 품사 태깅

CRF의 개념과 특징

Conditional Random Field(CRF)는 마르코프 랜덤 필드(MRF)의 일종으로, 각 노드가 주변 노드들의 상태에 영향을 받는 확률 모델입니다. CRF는 입력 데이터와 레이블 사이의 관계를 모델링하여, 입력 데이터에서 레이블을 추론하는 작업에 사용됩니다.

CRF는 다음과 같은 특징을 가집니다.

- 전체 문장을 고려한 태깅이 가능합니다.

- 입력 데이터에서 다양한 피처를 추출하여 활용할 수 있습니다.

- 입력 데이터의 임의의 길이를 다룰 수 있습니다.

CRF를 이용한 품사 태깅 과정

CRF를 이용한 품사 태깅은 다음과 같은 과정으로 이루어집니다.

- 훈련 데이터셋에서 각 단어와 품사의 조합에 대한 빈도수를 계산합니다.

- 각 단어의 시작과 끝에 <start>와 <end> 태그를 추가합니다.

- 각 단어에 대해 가능한 모든 품사에 대한 피처를 추출합니다.

- 피처를 이용하여 CRF 모델을 학습합니다.

- 테스트 문장에 대해 CRF 모델을 이용하여 품사 태깅을 수행합니다.

- 태깅된 문장의 정확도를 평가합니다.

Python을 사용한 CRF 품사 태깅 예제 코드

Python의 sklearn-crfsuite 라이브러리를 사용하여 CRF를 이용한 품사 태깅을 수행할 수 있습니다. 아래는 예제 코드입니다.

import nltk

import sklearn_crfsuite

# 학습 데이터 로드

tagged_sentences = nltk.corpus.treebank.tagged_sents()

# 피처 추출

def word2features(sent, i):

word = sent[i][0]

features = {

'bias': 1.0,

'word.lower()': word.lower(),

'word[-3:]': word[-3:],

'word[-2:]': word[-2:],

'word.isupper()': word.isupper(),

'word.istitle()': word.istitle(),

'word.isdigit()': word.isdigit(),

}

if i > 0:

prev_word = sent[i-1][0]

features.update({

'prev_word.lower()': prev_word.lower(),

'prev_word.istitle()': prev_word.istitle(),

'prev_word.isupper()': prev_word.isupper })

else:

features['BOS'] = True

if i < len(sent)-1:

next_word = sent[i+1][0]

features.update({

'next_word.lower()': next_word.lower(),

'next_word.istitle()': next_word.istitle(),

'next_word.isupper()': next_word.isupper(),

})

else:

features['EOS'] = True

return features

def sent2features(sent):

return [word2features(sent, i) for i in range(len(sent))]

def sent2labels(sent):

return [tag for word, tag in sent]

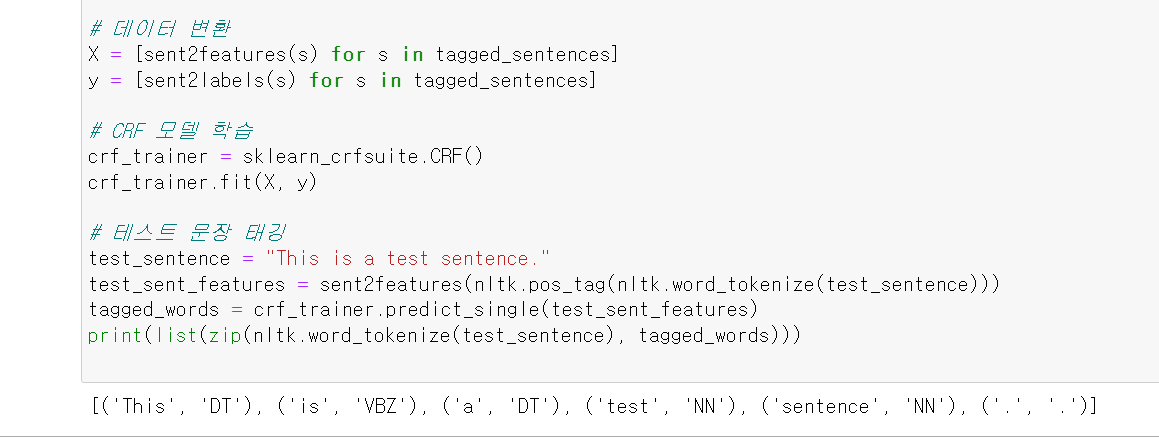

# 데이터 변환

X = [sent2features(s) for s in tagged_sentences]

y = [sent2labels(s) for s in tagged_sentences]

# CRF 모델 학습

crf_trainer = sklearn_crfsuite.CRF()

crf_trainer.fit(X, y)

# 테스트 문장 태깅

test_sentence = "This is a test sentence."

test_sent_features = sent2features(nltk.pos_tag(nltk.word_tokenize(test_sentence)))

tagged_words = crf_trainer.predict_single(test_sent_features)

print(list(zip(nltk.word_tokenize(test_sentence), tagged_words)))

위 예제 코드에서는 NLTK의 treebank 데이터셋에서 학습 데이터를 로드하고, 피처를 추출합니다. 그리고, sklearn-crfsuite 라이브러리를 이용하여 CRF 모델을 학습하고, 테스트 문장에 대해 품사 태깅을 수행합니다.

CRF를 이용한 품사 태깅은 문맥을 고려하기 때문에, HMM보다 높은 정확도를 보입니다. 따라서, 자연어 처리 분야에서는 CRF를 이용한 품사 태깅이 많이 활용됩니다.

통계 기반 접근법의 한계와 대안

통계 기반 접근법의 한계

통계 기반 접근법은 언어 모델링을 위해 다양한 통계적 기법을 이용하여 문장에서 단어의 시퀀스를 추론하는 방식입니다. 하지만, 통계 기반 접근법은 다음과 같은 한계가 있습니다.

- 문장 내 단어 간 상호작용을 고려하지 않습니다.

- 문맥이 미치는 영향을 제대로 반영하지 못합니다.

- 규칙 기반 접근법으로 구현이 어렵습니다.

이러한 한계로 인해, 통계 기반 접근법은 정확도가 떨어지는 경우가 많습니다.

통계 기반 접근법과 딥 러닝 접근법의 비교

딥 러닝 접근법은 인공 신경망을 이용하여 자연어 처리를 수행하는 방식입니다. 통계 기반 접근법과 비교하여 딥 러닝 접근법은 다음과 같은 특징을 가집니다.

- 문맥을 고려하여 모델링할 수 있습니다.

- 인공 신경망의 높은 유연성으로 다양한 피처를 활용할 수 있습니다.

- 일부 모델에서는 규칙 기반 접근법을 적용할 수 있습니다.

딥 러닝 접근법은 통계 기반 접근법과 비교하여 더 높은 정확도를 보입니다.

통계 기반 접근법과 딥 러닝 접근법의 조합

통계 기반 접근법과 딥 러닝 접근법을 조합하여 사용할 수 있습니다. 예를 들어, 통계 기반 접근법을 이용하여 초기 태깅 결과를 생성하고, 이를 딥 러닝 접근법의 입력으로 사용하는 방식입니다. 이러한 방식은 딥 러닝 접근법의 높은 정확도와 통계 기반 접근법의 빠른 속도를 모두 활용할 수 있습니다.

최근 자연어 처리 분야에서는 통계 기반 접근법과 딥 러닝 접근법을 조합하여 사용하는 경우가 많습니다. 이러한 방식은 대용량 데이터에 대한 딥 러닝 접근법의 장점과 동시에, 적은 데이터에 대한 통계 기반 접근법의 장점을 모두 활용할 수 있습니다.

예를 들어, 통계 기반 접근법을 이용하여 대량의 데이터를 이용하여 초기 모델을 학습하고, 이를 딥 러닝 접근법의 초기 가중치로 활용하는 방식이 있습니다. 또한, 통계 기반 접근법을 이용하여 예측 결과를 생성하고, 이를 딥 러닝 접근법의 입력으로 사용하여 성능을 향상시키는 방식도 있습니다.

딥 러닝 접근법의 발전으로 인해 통계 기반 접근법은 대체되어 가고 있지만, 통계 기반 접근법의 장점을 활용하여 효율적인 모델 학습을 수행하는 방식도 많이 연구되고 있습니다.

결론

통계 기반 접근법과 딥 러닝 접근법은 각각의 장단점을 가지고 있습니다. 따라서, 자연어 처리 분야에서는 두 접근법을 조합하여 사용하는 경우가 많습니다. 앞으로도 효과적인 자연어 처리 기술을 개발하기 위해, 통계 기반 접근법과 딥 러닝 접근법을 함께 연구하여 보다 높은 성능을 발휘할 수 있는 방법을 모색해야 합니다.

이 글을 ChatGPT의 도움을 받아 작성되었습니다.

'ChatGPT > 인공지능' 카테고리의 다른 글

| [자연어처리] Python을 활용한 POS 태깅 모델링: Hidden Markov Model 학습 방법 (0) | 2023.04.30 |

|---|---|

| [자연어처리][PYTHON] Peter Norvig의 베이지안 스펠링 체커 (0) | 2023.04.22 |

| [자연어처리][PYTHON] 규칙기반 품사 태깅 (0) | 2023.04.21 |

| [자연어처리][PYTHON] 베이지안 추론 모델을 이용한 스펠링 체커 만들기 (0) | 2023.04.19 |

| [정보이론][엔트로피] - Entropy 소개 (0) | 2023.04.19 |