1. 들어가며

1.1 Docker와 GPU 환경의 중요성 소개

최근 딥러닝 기술은 인공지능 및 머신러닝 분야의 주요 기술로 자리매김하고 있습니다. 딥러닝 모델을 효율적으로 개발하고 학습하기 위해서는 GPU를 활용한 컴퓨팅 환경이 필수적입니다. Docker는 이러한 GPU 환경을 빠르고 편리하게 구축할 수 있는 도구로서 많은 개발자들에게 인기를 얻고 있습니다.

1.2 이 글의 목적 및 대상 독자 소개

이 글에서는 Docker를 사용하여 GPU 환경을 구축하는 방법에 대해 소개합니다. NVIDIA GPU를 기반으로 한 환경 구축 과정을 단계별로 설명하고, 실제 딥러닝 프레임워크를 사용하는 예제를 제공합니다.

이 글은 다음과 같은 대상 독자를 염두에 두고 작성되었습니다.

- 딥러닝 및 머신러닝에 관심이 있는 개발자

- GPU 환경에서 딥러닝 모델을 개발하고 싶은 개발자

- Docker를 사용하여 개발 환경을 구축하고자 하는 개발자

2. 사전 준비: 필수 도구 설치

먼저, Docker와 GPU 환경 구축을 위해 필요한 도구들을 설치하겠습니다.

2.1 Docker 설치 및 기본 사용법

Docker를 사용하려면 먼저 Docker를 설치해야 합니다. 아래 링크에 따라 Docker를 설치하세요.

- Docker Desktop for Windows: https://docs.docker.com/desktop/windows/install/

- Docker Desktop for Mac: https://docs.docker.com/desktop/mac/install/

- Docker Engine for Linux: https://docs.docker.com/engine/install/

Docker가 설치되면 다음 명령어를 실행하여 정상적으로 작동하는지 확인하세요.

docker --version

2.2 NVIDIA GPU 드라이버 설치

GPU 환경 구축을 위해 호환되는 NVIDIA GPU 드라이버를 설치해야 합니다. 최신 드라이버를 찾으려면 NVIDIA 공식 웹사이트를 방문하세요: https://www.nvidia.com/Download/index.aspx

드라이버가 설치되면 다음 명령어를 실행하여 정상적으로 작동하는지 확인하세요.

nvidia-smi

이제 Docker 및 NVIDIA GPU 드라이버가 준비되었습니다. 다음 단계에서는 NVIDIA Docker를 설치하고 설정하는 방법을 알아보겠습니다.

3. NVIDIA Docker 설치 및 설정

이제 NVIDIA Docker를 설치하고 설정하는 방법을 살펴보겠습니다.

3.1 NVIDIA Docker 소개

NVIDIA Docker는 Docker와 NVIDIA GPU를 함께 사용할 수 있게 해주는 도구입니다. 이를 통해 GPU가 지원되는 Docker 이미지를 사용하여, 간편하게 딥러닝 개발 환경을 구축할 수 있습니다.

3.2 NVIDIA Docker 설치 방법

NVIDIA Docker의 최신 버전을 설치하려면, 아래 공식 설치 가이드를 참고하여 설치하세요.

- NVIDIA Docker 설치 가이드: https://github.com/NVIDIA/nvidia-docker

설치가 완료되면, 다음 명령어를 실행하여 정상적으로 작동하는지 확인하세요.

docker run --rm --gpus all nvidia/cuda:11.0.3-base-ubuntu20.04 nvidia-smi

3.3 설치 확인 및 기본 사용법

위 명령어가 정상적으로 실행되면, NVIDIA Docker가 올바르게 설치된 것입니다. 이제 Docker 컨테이너를 실행할 때 --gpus all 옵션을 추가하면, 해당 컨테이너에서 GPU를 사용할 수 있습니다.

다음 단계에서는 GPU를 지원하는 Docker 이미지를 선택하고 실행하는 방법을 알아보겠습니다.

4. GPU를 지원하는 Docker 이미지 선택

이제 GPU를 지원하는 Docker 이미지를 선택하여, 실제 딥러닝 개발 환경을 구축해 보겠습니다.

4.1 TensorFlow, PyTorch 등 주요 딥러닝 프레임워크의 공식 이미지 소개

TensorFlow와 PyTorch는 현재 가장 인기 있는 딥러닝 프레임워크입니다. 이들 프레임워크는 GPU를 지원하는 공식 Docker 이미지를 제공하므로, 개발 환경을 빠르게 구축할 수 있습니다.

- TensorFlow 공식 이미지: https://hub.docker.com/r/tensorflow/tensorflow/

- PyTorch 공식 이미지: https://hub.docker.com/r/pytorch/pytorch/

4.2 이미지 다운로드 방법 및 사용법

공식 이미지를 다운로드하려면, 아래와 같은 명령어를 실행하세요.

docker pull tensorflow/tensorflow:latest-gpu

docker pull pytorch/pytorch:latest

이미지가 정상적으로 다운로드되면, 다음 명령어를 실행하여 컨테이너를 생성하고 실행할 수 있습니다.

docker run --gpus all -it --rm tensorflow/tensorflow:latest-gpu

docker run --gpus all -it --rm pytorch/pytorch:latest

이제 GPU를 지원하는 Docker 이미지를 선택하고 실행하는 방법을 알았습니다. 다음 단계에서는 Docker 컨테이너를 실행하고 GPU를 활용하는 방법을 살펴보겠습니다.

5. Docker 컨테이너에서 GPU 활용하기

이제 Docker 컨테이너를 실행하고, 실제로 GPU를 활용하여 딥러닝 모델을 학습하는 방법을 알아보겠습니다.

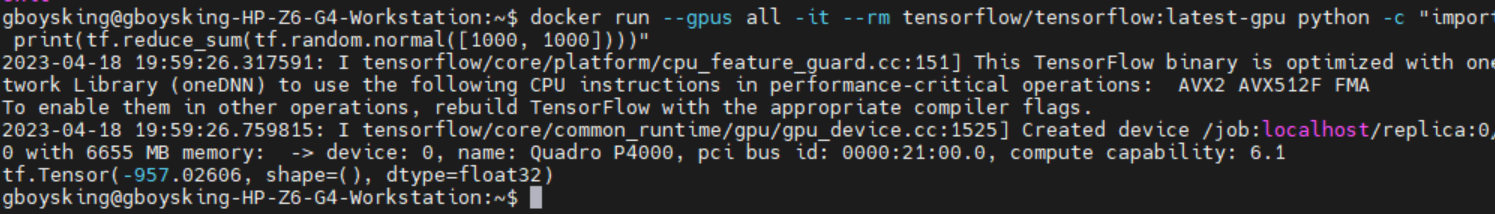

5.1 TensorFlow 예제

GPU를 사용하는 TensorFlow Docker 이미지를 실행하기 위해서는 다음과 같은 명령어를 실행합니다.

docker run --gpus all -it --rm tensorflow/tensorflow:latest-gpu python -c "import tensorflow as tf; print(tf.reduce_sum(tf.random.normal([1000, 1000])))"

위 명령어는 TensorFlow의 GPU 버전 이미지에서 간단한 연산을 수행하는 예제입니다. 정상적으로 실행되면, GPU를 사용하여 연산이 수행되었음을 확인할 수 있습니다.

5.2 PyTorch 예제

GPU를 사용하는 PyTorch Docker 이미지를 실행하기 위해서는 다음과 같은 명령어를 실행합니다.

docker run --gpus all -it --rm pytorch/pytorch:latest python -c "import torch; print(torch.cuda.is_available())"

위 명령어는 PyTorch의 GPU 버전 이미지에서 GPU 사용 가능 여부를 확인하는 예제입니다. 정상적으로 실행되면, GPU를 사용할 수 있음을 확인할 수 있습니다.

이제 Docker를 사용하여 GPU 환경에서 딥러닝 모델을 개발하고 학습하는 방법을 알았습니다. GPU 환경 구축을 위한 모든 준비가 완료되었으므로, 실제 딥러닝 프로젝트를 시작할 준비가 되었습니다.

6. Docker 볼륨 및 네트워킹 설정하기

이제 딥러닝 개발 환경이 완성되었으니, Docker 컨테이너와 호스트 시스템 간에 파일을 주고받기 위한 볼륨 설정과 네트워킹 설정을 해보겠습니다.

6.1 Docker 볼륨 설정

Docker 볼륨은 컨테이너와 호스트 시스템 간에 데이터를 주고받을 수 있게 해주는 기능입니다. 이를 통해 컨테이너 내부에서 작성한 코드나 학습한 모델을 호스트 시스템에 저장할 수 있습니다.

볼륨을 설정하는 방법은 다음과 같습니다.

docker run -v [호스트 디렉토리]:[컨테이너 디렉토리] ...

예를 들어, 호스트 시스템의 /home/user/project 디렉토리를 TensorFlow 컨테이너의 /app 디렉토리와 연결하려면 다음과 같이 실행합니다.

docker run --gpus all -it --rm -v /home/user/project:/app tensorflow/tensorflow:latest-gpu6.2 Docker 네트워킹 설정

Docker 네트워킹을 설정하면, 컨테이너 간에 통신이 가능하며 외부 네트워크와도 연결할 수 있습니다.

예를 들어, Jupyter Notebook을 실행하는 TensorFlow 컨테이너를 생성하고 외부 네트워크와 연결하려면 다음과 같이 실행합니다.

docker run --gpus all -it --rm -p 8888:8888 tensorflow/tensorflow:latest-gpu-jupyter

위 명령어는 호스트 시스템의 8888 포트를 컨테이너의 8888 포트와 연결합니다. 이렇게 설정하면, 호스트 시스템의 웹 브라우저에서 http://localhost:8888로 접속하여 Jupyter Notebook을 사용할 수 있습니다.

이제 Docker 볼륨과 네트워킹을 설정하는 방법을 알았습니다. 이를 활용하여 실제 딥러닝 프로젝트를 진행할 수 있습니다.

7. 정리 및 마무리

이 글에서는 Docker와 GPU 환경을 함께 사용하여 딥러닝 개발 환경을 구축하는 방법에 대해 알아보았습니다. 정리하면 다음과 같습니다.

- 필수 도구 설치: Docker, NVIDIA GPU 드라이버 설치

- NVIDIA Docker 설치 및 설정

- GPU를 지원하는 Docker 이미지 선택: TensorFlow, PyTorch 공식 이미지

- Docker 컨테이너에서 GPU 활용하기: TensorFlow, PyTorch 예제

- Docker 볼륨 및 네트워킹 설정

이제 Docker와 GPU 환경을 사용하여 딥러닝 개발 환경을 구축하고, 실제 딥러닝 프로젝트를 진행할 준비가 되었습니다. 앞으로의 딥러닝 개발에 도움이 되길 바랍니다.

이글은 ChatGPT 도움을 받아 작성되었습니다.

'ChatGPT > Docker' 카테고리의 다른 글

| [Docker][Container] 도커 명령어 모음 (0) | 2023.04.24 |

|---|---|

| [Docker][Image] 도커 명령어 모음 (0) | 2023.04.24 |

| [Docker] Dockerfile 작성 방법 (0) | 2023.04.21 |

| [Docker][UI]Portainer - 도커 쉽게 관리하자 (0) | 2023.04.19 |

| [Docker][Swarm] Task Slot (0) | 2023.04.16 |